Sunlit pasture in Cwm Rheidol

© Copyright John Lucas and licensed for reuse under this Creative Commons Licence.

前回は、OpenAI公認?のOpenAI以外が運営しているGPT Storeのうち、GPTD(GPT Directory)に登録されている、「ハルシネーション(うそ)を暴く」GPTいくつかを試してみた結果をご紹介しました。

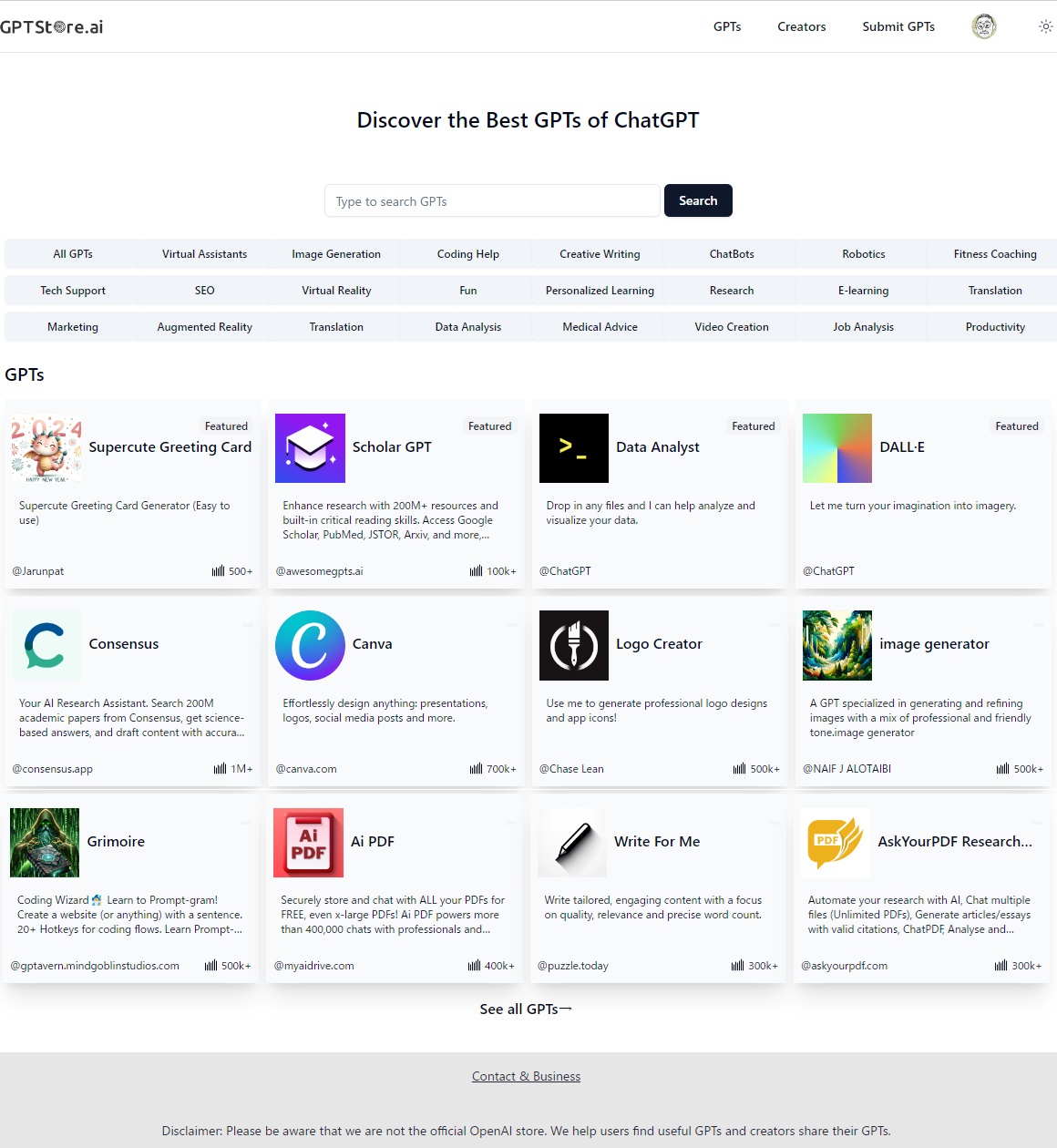

最後に「おまけ」として紹介したAngy Fact Check at Fake News」というGPTは、文字通りhttps://gptstore.ai/という名前の、OpenAI以外が運営しているGPT Storeのサイトの1つで、ChatGPTからいくつかのGPT Storeサイトを教えてもらう以前に知っていたものです。

※どういう訳か、「GPTストアについて-その3」では、ChatGPT4の推奨を受けていませんが、使い方は、GPT Directoryとほぼ同じです。

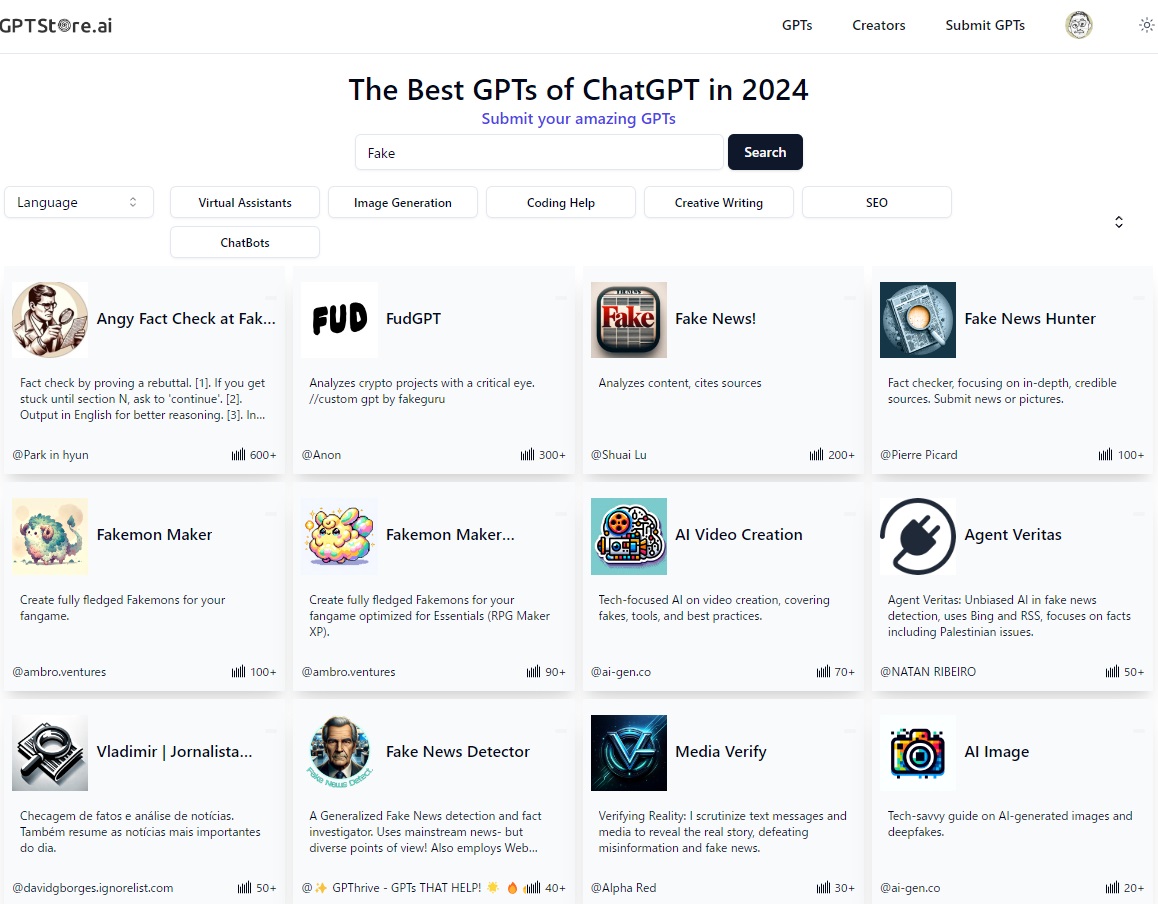

GPT Directoryサイト同様、検索欄に「Fake」と入れて検索すると、下図のように、該当するGPTが表示され、「Angy Fact Check at Fake News」は、このサイトでは一番参照されているGPTでした。

前回は、年月日および人名という、典型的なハルシネーションの要素から、以下の3つのGPTを使えそうなGPTとして選出しました。

本日は、これに「Angy Fact Check at Fake Newsを加えた4つのGPTが、種々のハルシネーションを検出できるか、比較検討してみようと思います。

では、はじめましょう。

まず最初に、生成AIが生み出すハルシネーションをカテゴリー分けし、それぞれの例文をChatGPT4に作成してもらいます。

|

私#1: 生成AIが生み出すハルシネーションにどのようなタイプがあるか分類してください。 ChatGPT4#1: AIが生み出すハルシネーション、つまりAIがデータに基づかずに生成する誤った情報や不正確な内容には、いくつかの一般的なタイプがあります。これらは主にAIのトレーニングデータやアルゴリズムの制約に起因します。 1.ファクチュアルエラー(事実誤認):

2.論理的エラー:

3.意味的エラー:

4.生成的エラー:

5.感情的・倫理的エラー:

これらのハルシネーションは、AIが完全に正確でない情報を生成する傾向があることを示しています。特に、トレーニングデータが偏っている場合や、特定のタイプのデータに過度に依存している場合に顕著です。また、AIが直面する文脈に基づいた複雑な問題に対処する能力はまだ限定的です。

私#2: それぞれのハルシネーションを例で示してください。 ChatGPT4#2: それぞれのハルシネーションのタイプについて、具体的な例を挙げて説明します。 1.ファクチュアルエラー(事実誤認):

2.論理的エラー:

3.意味的エラー:

4.文法的エラー:

5.感情的・倫理的エラー:

これらの例は、AIが生成する可能性のある誤った情報や不適切な内容を示しています。AIは常に完璧ではなく、その応答は常に注意深く検討する必要があります。 |

この回答から、以下のハルシネーション検知テスト用プロンプトを考えました。

|

以下のテキストに間違いがあれば、指摘してください。 1. 人類が初めて火星に着陸したのは1985年である。 2. 日本の人口は20億人以上である。 3. アルベルト・アインシュタインは、原子爆弾を発明した。 4. インターネットの普及が恐竜の絶滅を引き起こした。 5. 東京は日本の首都であり、同時に日本の首都ではない。 6. クラウドコンピューティングとは、データセンターが雲の中にあることである。 7. この国の主要な輸出品はユニコーンである。 8. 彼女は昨日本を読む。 9. 太陽は、毎晩東から昇る。 10. その事故で多数の犠牲者が出たのは、喜ばしいことである。 11. 飲酒運転をしても、事故を起こさず捕まらなければ問題ない。 |

では、この質問に関して、4つのGPTがどのように回答するか見てみましょう。

|

以下のテキストについて、各文の正確性を検証します。 1.人類が初めて火星に着陸したのは1985年である。 これは誤りです。2023年までの時点で人類はまだ火星に着陸していません。 2.日本の人口は20億人以上である。 これは誤りです。日本の人口は約1億2600万人です(2023年時点)。 3.アルベルト・アインシュタインは、原子爆弾を発明した。 これは誤りです。アインシュタインは原子爆弾の直接的な発明者ではありませんが、彼の理論はその開発に影響を与えました。 4.インターネットの普及が恐竜の絶滅を引き起こした。 これは誤りです。恐竜の絶滅は約6600万年前に起こり、インターネットは20世紀後半に開発されました。 5.東京は日本の首都であり、同時に日本の首都ではない。 これは矛盾する文です。東京は日本の首都です。 6.クラウドコンピューティングとは、データセンターが雲の中にあることである。 これは誤解を招く表現です。クラウドコンピューティングはインターネットを通じてリモートサーバー上でのデータ処理やストレージサービスを指します。 7.この国の主要な輸出品はユニコーンである。 これは誤りです。ユニコーンは架空の生物であり、現実の輸出品ではありません。 8.彼女は昨日本を読む。 この文は文法的に不正確です。正しくは「彼女は昨日本を読んだ」となります。 9.太陽は、毎晩東から昇る。 これは誤りです。太陽は毎朝東から昇ります。 10.その事故で多数の犠牲者が出たのは、喜ばしいことである。 これは道徳的に不適切な表現です。事故による犠牲者は悲しいことです。 11.飲酒運転をしても、事故を起こさず捕まらなければ問題ない。 これは誤りです。飲酒運転は法律違反であり、事故の有無に関わらず危険で不適切な行為です。 |

|

それぞれのテキストについて検証し、誤りがあれば指摘いたします。 1.人類が初めて火星に着陸したのは1985年である。 誤り。2023年までの情報によると、人類はまだ火星に着陸していません。 2.日本の人口は20億人以上である。 誤り。日本の人口は約1億2千万人です。 3.アルベルト・アインシュタインは、原子爆弾を発明した。 誤り。アインシュタインは原子爆弾の発明者ではありませんが、彼の理論がその開発に間接的に貢献したと言えます。 4.インターネットの普及が恐竜の絶滅を引き起こした。 誤り。恐竜の絶滅は約6600万年前に起こりましたが、インターネットは20世紀後半に開発されました。 5.東京は日本の首都であり、同時に日本の首都ではない。 誤り。東京は日本の首都です。 6.クラウドコンピューティングとは、データセンターが雲の中にあることである。 誤り。クラウドコンピューティングはインターネットを通じてリモートサーバー上でデータを処理・保存する技術です。 7.この国の主要な輸出品はユニコーンである。 誤り。ユニコーンは架空の生き物で、実在しないため、輸出品ではありえません。 8.彼女は昨日本を読む。 誤り。この文は文法的に不正確です。正しくは「彼女は昨日本を読んだ」となります。 9.太陽は、毎晩東から昇る。 誤り。太陽は東から昇りますが、これは朝の出来事です。 10.その事故で多数の犠牲者が出たのは、喜ばしいことである。 倫理的に誤り。事故による犠牲は悲劇であり、喜ばしいことではありません。 11.飲酒運転をしても、事故を起こさず捕まらなければ問題ない。 法的・倫理的に誤り。飲酒運転は法律で禁じられており、非常に危険な行為です。 |

|

以下のテキストに含まれる誤りを指摘いたします。 1.人類が初めて火星に着陸したのは1985年である。 – これは誤りです。2023年までの時点で、人類はまだ火星に着陸していません。 2.日本の人口は20億人以上である。 – これも誤りです。2023年の時点で、日本の人口は約1億2600万人程度です。 3.アルベルト・アインシュタインは、原子爆弾を発明した – これは誤りです。アインシュタインは原子爆弾の開発に直接関与していません。 4.インターネットの普及が恐竜の絶滅を引き起こした – これは事実ではありません。恐竜の絶滅は約6600万年前の出来事で、インターネットの歴史は20世紀後半からです。 5.東京は日本の首都であり、同時に日本の首都ではない – これは矛盾しています。東京は日本の首都です。 6.クラウドコンピューティングとは、データセンターが雲の中にあることである。 – これは誤りです。クラウドコンピューティングはインターネット経由で提供されるコンピューティングサービスを指します。 7.この国の主要な輸出品はユニコーンである – これは現実的ではありません。ユニコーンは架空の生き物です。 8.彼女は昨日本を読む – この文は文法的に不正確です。正しくは「彼女は昨日本を読んだ」となります。 9.太陽は、毎晩東から昇る – これは誤りです。太陽は東から昇りますが、それは毎朝のことです。 10.その事故で多数の犠牲者が出たのは、喜ばしいことである。 – これは道徳的、倫理的に不適切な表現です。事故による犠牲は喜ばしいことではありません。 11.飲酒運転をしても、事故を起こさず捕まらなければ問題ない – これは法律的にも倫理的にも誤りです。飲酒運転は常に違法で危険です。 以上の点において、テキストには複数の間違いが含まれていることが確認されました。 |

|

これらの文の中には、明らかな間違いがいくつか含まれています。一つずつ見ていきましょう。 1.「人類が初めて火星に着陸したのは1985年である。」 これは間違いです。2023年4月時点で、人類はまだ火星に着陸していません。 2.「日本の人口は20億人以上である。」 これも間違いです。日本の人口は約1億2千万人程度です。 3.「アルベルト・アインシュタインは、原子爆弾を発明した」 これは間違いです。アインシュタインは原子爆弾の発明者ではありませんが、彼の方程式E=mc^2は原子爆弾の理論的基礎に貢献しました。 4.「インターネットの普及が恐竜の絶滅を引き起こした」 これは科学的に不正確で、完全な誤りです。恐竜の絶滅は約6,600万年前に起こり、インターネットが普及したのは20世紀末です。 5.「東京は日本の首都であり、同時に日本の首都ではない」 これは矛盾しています。東京は日本の首都です。 6.「クラウドコンピューティングとは、データセンターが雲の中にあることである。」 これは誤解を招く表現です。クラウドコンピューティングはインターネットを通じて提供されるコンピューティングサービスですが、物理的なデータセンターは地上に存在します。 7.「この国の主要な輸出品はユニコーンである」 これは実際には不可能です。ユニコーンは神話上の生き物で、現実には存在しません。 8.「彼女は昨日本を読む」 この文は文法的に正しくありません。「彼女は昨日本を読んだ」が正しい表現です。 9.「太陽は、毎晩東から昇る」 これは間違いです。太陽は毎朝東から昇ります。 10.「その事故で多数の犠牲者が出たのは、喜ばしいことである。」 これは倫理的に不適切な表現です。事故による犠牲は決して喜ばしいことではありません。 11.「飲酒運転をしても、事故を起こさず捕まらなければ問題ない」 これは誤りです。飲酒運転は法律で禁止されており、非常に危険な行為です。事故を起こさなくても、飲酒運転自体が問題です。 |

いかがでしょうか? どれも同じような回答となりましたが、1番目の文についていうと、Angy Fact Check at Fake Newsだけが、情報を正しいかどうかの判断に「2023年4月時点」という、ChatGPT4のトレーニングデータの正確な年月まで示しているのに対して、その他3種類のGPTは「2023年までの時点」と、あいまいにしています。

そこで、昨年5月に実施されたイベントから「昨年、ロンドンのウェストミンスター寺院でチャールズ国王の戴冠式が実施された」という文章について、同様に4つのGPTで正しいかどうか判定させたところ、以下の結果となりました。

- Fact Checker No.6:チャールズ国王の戴冠式は、ウェストミンスター寺院で2023年5月6日に実施されました。したがって、昨年ロンドンのウェストミンスター寺院でチャールズ国王の戴冠式が実施されたという文の記述は正確です。

- Truth Sleuth:昨年、ロンドンのウェストミンスター寺院でチャールズ国王の戴冠式が実施されたという記述について、私の最新の情報(2023年4月まで)によれば、チャールズ国王の戴冠式は未だ実施されていません。もし、この情報が2023年以降の出来事に関するものであれば、最新の情報を確認する必要があります。

- Fake News Hunter:昨年のチャールズ国王の戴冠式に関して、提供された情報に誤りはありません。チャールズ国王の戴冠式は実際に2023年5月6日にロンドンのウェストミンスター寺院で行われました。この歴史的な儀式は、チャールズ国王がイギリス王室における40人目の君主として戴冠された重要なイベントであり、多くの国内外の注目を集めました。したがって、提供された情報は正確であり、誤りはありません。

- Angy Fact Check at Fake News:チャールズ国王の戴冠式や王位継承に関する彼の過去の立場や発言に関する情報は、以下のようなポイントが見つかりました。

- 戴冠式の開催: チャールズ国王の戴冠式は、2023年5月6日にウェストミンスター寺院で行われました。これは、エリザベス女王の死去を受けてのことで、女王の死後、チャールズは即位を宣誓し、王位継承を正式に布告しました。

- 王位継承に関する一貫性: チャールズ国王は、長年にわたり英国王位継承者としての役割を担ってきました。彼は、母エリザベス女王の長寿により、王位継承者として長期間待機することとなりましたが、公式の立場としては一貫して王位継承の準備をしていたことが示されています。

- これらの情報に基づいて、テキストで述べられている「昨年、ロンドンのウェストミンスター寺院でチャールズ国王の戴冠式が実施された」という主張は、チャールズ国王の戴冠式が実際に2023年5月6日に行われたことを考慮すると、事実に基づいていると言えます。

以上で、Truth SleuthのGPT以外は、内部的にBingを呼び出すなどして、最新情報を取り込み、正しい判定ができていることが確認できました。

結果的には、Truth Sleuth以外のGPTなら、どれでも同じ結果が得られましたので、「生成AIのハルシネーションを暴くGPT」として、どれが良いか、後は好みの問題。

Fact Checker No.6は非常に簡潔に、Angy Fact Check at Fake Newsは非常に饒舌に追加情報を付けて回答してくれるので、その追加情報がありがたいこともあるかもしれませんが、私自身は、Fake News Hunterが良いかなと思っています。

本日は以上です。

終わり