Shepherd’s cottage in the Broughton hills

© Copyright Jim Barton and licensed for reuse under this Creative Commons Licence.

.

ここしばらく、「生成AIのハルシネーション対策」というテーマで、

- 「その1」では、Cohere社のCoral(OpenAIのChatGPTに相当する、Cohere社の生成AIであるCommand R+のチャットボット)、

- 「その2」では、Mistral AIのLe Chat、

- 「その3」では、AnthropicのClaude、

- 「その4」では、GoogleのGemini 1.5 Pro、

- 「その5」では、MicrosoftのCopilot、

- 「その6」では、OpenAIのChatGPT-4、

に、自らのハルシネーション対策を語ってもらいました。

CohereのCoralは、ハルシネーションを「モデルが実際の入力データに存在しないパターンや物体を検出したり認識したりする現象」と捉えています。そして、これは、学習データの偏りや質の低さが原因であり、データセットの改善と、出力の事実性を確認するためのアルゴリズムの強化が重要としています。Coralはまた、Grounding機能やRAG(Retrieval-Augmented Generation)を活用して、外部知識を参照しながら応答を生成することで、ハルシネーションを減らす対策を取っています。

Mistral AIのLe Chatは、ハルシネーションを「モデルが誤った情報や存在しない事実を生成すること」と定義しています。データセットの改善やキャリブレーション技術の導入により、ハルシネーションのリスクを軽減することを目指しており、モデルの信頼度スコアの調整、ユーザーからのフィードバックの活用、人間による評価などを、重要な対策として実施しています。さらに、RAGの導入により、外部情報を参照して出力の正確性を高めています。

AnthropicのClaude 3は、ハルシネーションを「現実とは異なる出力」として捉え、モデルの設計やデータセットの改善、適切な評価とフィルタリングを通じて、その発生を最小限に抑えることを目指しています。Claude 3は、データの多様性と質の向上、信頼度の評価、人間によるモニタリングとフィードバックなどを重要視し、RAGモデルの活用により、外部知識ベースから情報を検索し、正確な出力を生成することに努めています 。

Google Gemini 1.5Proは、ハルシネーションを避けられない課題としつつも、克服に向けた様々な取り組みが進行中であるとしています。ハルシネーションの原因として、訓練データの問題や訓練・推論段階の問題を挙げ、対策として、データセットの改善やモデル・アルゴリズムの改良、評価指標の開発などが行われています。特に、出力内容の信頼性を高めるために、事実誤認がないか、論理的に矛盾していないかをチェックする機能が組み込まれているそうです。

Microsoft Copilotは、ハルシネーションを「AIが存在しない情報やデータを生成する現象」と定義しています。そして、生成AIは、学習したデータから新しい情報を推測し出力する能力を持っていますが、常に正確な結果をもたらすわけではないからとしています。Copilotは、データセットの多様性と質を向上させること、ユーザーからのフィードバックを活用すること、安全性と倫理性を確保することを通じて、ハルシネーションのリスクを最小限に抑えるよう努めているとしています。

OpenAIのChatGPT-4は、ハルシネーションを「事実でない情報を生成すること」としています。これは、AIが大量のテキストデータを学習する過程で、データ内のパターンや関連性を解釈し、新しい回答を生成する際に発生します。ChatGPT-4は、より大規模で多様なデータセットを使用し、Reinforcement Learning from Human Feedback (RLHF) や模倣学習を通じてモデルの精度を向上させることで、ハルシネーションの発生を減らす対策を取っていると説明しています。

今回、それぞれの生成AIに自分のハルシネーション対策を語ってもらったため、その内容をもって、生成AIのハルシネーション対策の良し悪しを比較評価する意味があるかどうか迷ったのですが、6つのブログ記事をChatGPT-4Vに読み込ませて、以下のプロンプトで比較評価作業を行ってみました。

|

私: 1)UPした6種類の生成AIのハルシネーション対策を読んで、比較評価するための評価軸を考えてください 2)UP下6種類の生成AIのハルシネーション対策の内容を、1)で作成した評価軸に関して評価し、評価軸ごとに、6種類の生成AIの評価(1:ダメ、2:それほど良くない、3:普通、4:まあまあ良い、5:非常に良い)のどれに該当するかを考えってください 3)生成AIのハルシネーション対策比較表として、縦軸に生成AIの種類、横軸には1,2,3,4,5段階のカラムを設け、各生成AIの、個々の評価項目に関しする評価値(1から5)を入れ、最後のカラムに「総合得点」として評価ごとの評価値を足し合わせた数値を入れた表を作成してください。 |

これに対するChatGPT-4の出力は以下の通りでした。

|

■ 評価軸の設定 生成AIのハルシネーション対策を評価するための評価軸を以下のように設定します: 1.データセットの改善

2.モデル・アルゴリズムの改良

3.評価指標の開発

4.ユーザーフィードバックの活用

5.人間による評価

6.その他の技術

■ 各生成AIの評価 評価軸ごとに、6種類の生成AIのハルシネーション対策について評価します。

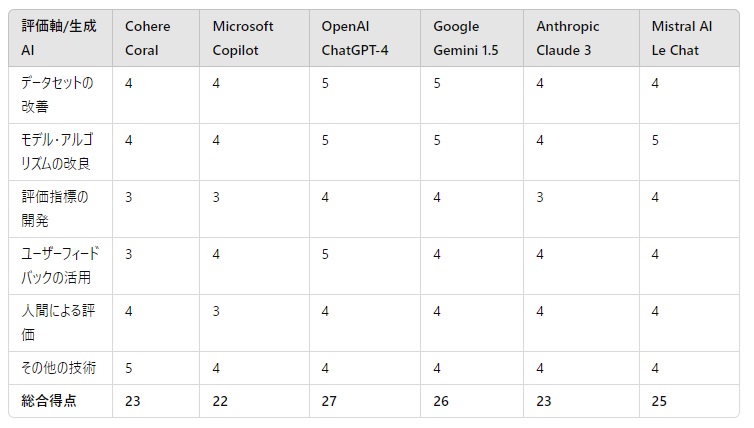

■ ハルシネーション対策比較表

|

ChatGPTによる6つの生成AIのハルシネーション対策に関する総合評価は、上表の通りとなりました。

ChatGPT-4が1位、Gemini 1.5が2位となり、実際にこれらの生成AIを使ってみて遭遇するハルシネーション発生の頻度と感覚的には合わないのですが。。。

本日は以上です。

おわり

- 投稿タグ

- ChatGPT, Claude 3, Command R+, Copilot, Gemini 1.5, Mistral AI, ハルシネーション