Across the ford to Penrhyn Isaf

© Copyright Alan Hughes and licensed for reuse under this Creative Commons Licence.

最近出てきた生成AIから順番に生成AIのハルシネーション対策について調べてきましたが、今回はGoogleのGemini 1.5がどのようなハルシネーション対策をしているのか確認したいと思います。

|

私#1: 生成AIにとって、ハルシネーションというのは不可避なものでしょうか? Gemini 1.5#1: 生成AIにおけるハルシネーションは、現時点では完全には避けられない課題と言えます。しかし、近年様々な研究開発が進められており、その克服に向けた取り組みが活発化しています。 ハルシネーションの原因 生成AIがハルシネーションを起こす原因としては、主に以下の2点が挙げられます。 訓練データの問題:

訓練・推論段階の問題:

ハルシネーションの対策 上記のような課題に対して、以下のような対策が研究されています。 データセットの改善:

モデル・アルゴリズムの改良:

評価指標の開発:

今後の展望 これらの対策技術の進歩により、将来的には生成AIにおけるハルシネーションの問題は大幅に改善されることが期待されています。しかし、完全に根絶することは難しいとされています。 生成AIを利用する際には、常にハルシネーションの可能性を念頭に置き、生成された内容を鵜呑みにせず、他の情報源と照らし合わせながら検証することが重要です。 参考情報

私#2: Gemini 1.5を開発するにあたってどのようなハルシネーション対策を行ったか教えてください。 Gemini 1.5#2: Gemini 1.5は、前モデルであるGemini 1.0よりも高度な言語モデルであり、より人間らしい文章を生成することができます。しかし、その一方で、ハルシネーションの問題も発生しやすくなっています。 Gemini 1.5の開発においては、以下の点に重点を置いてハルシネーション対策を行いました。 1. 訓練データの改善

2. モデル・アルゴリズムの改良

3. 評価方法の改善

4. 人間による評価

これらの対策の結果、Gemini 1.5はGemini 1.0よりもハルシネーションの発生率を大幅に低減することに成功しました。 しかし、完全には根絶することが難しい課題であるため、今後も研究開発を進め、さらにハルシネーション対策を強化していく予定です。 留意点 Gemini 1.5は、まだ開発段階のモデルであり、完璧ではありません。 ハルシネーションが発生する可能性があることを常に念頭に置き、生成された内容を鵜呑みにせず、他の情報源と照らし合わせながら検証することが重要です。 |

というGemini 1.5の回答なのですが、これまでの利用経験から、Gemini 1.5の示すURLは間違っていることが多い気がします。

※Gemini1.5#1の回答中、文字色=赤の部分をご覧ください。

なお、Gemini 1.5では、回答欄の下に以下のようないくつかのボタンが表示されます。

ここまでで何も言及がありませんでしたが、Gemini 1.5では、ハルシネーション問題に対処するため、回答内容を再確認する機能が導入されていて、それが右から2番目の「G」のボタンです。

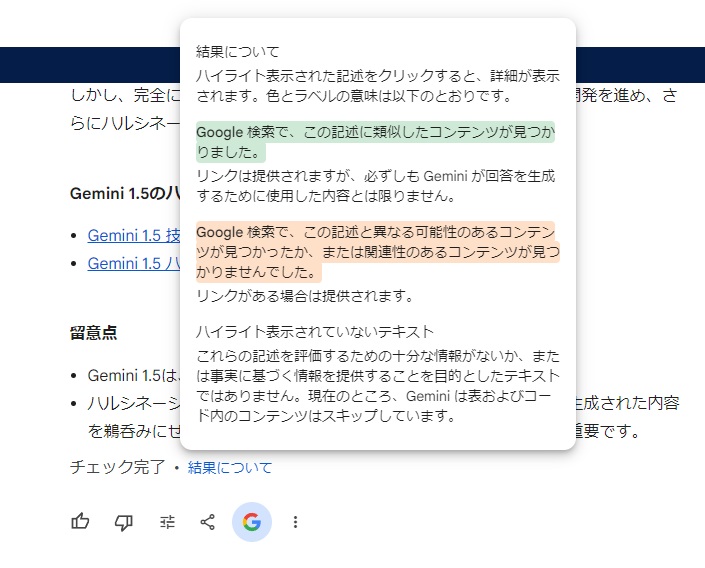

このボタンを押すと、Gemini 1.5は、自分の出力した内容に関してGoogle検索を利用してチェックし、チェックが完了すると、下図の通り、「チェック完了・結果について」と表示するとともに、ハルシ―ネーションの可能性がある解答部分の背景色がサーモンピンクに変更されていました。また、「結果について」部分をクリックすると、下図のとおり、「結果について」のポップアップ画面でハイライト表示した部分についての説明が出てきました。

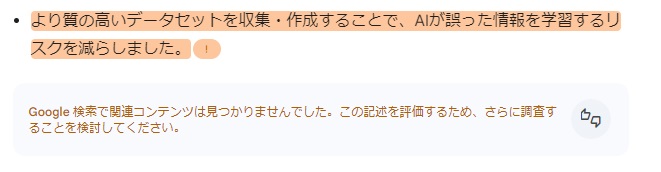

また、ハイライト表示された文章部分をクリックすると、その下に以下のような表示が現れました。

ここまで、いろいろな生成AIに「生成AIにとって、ハルシネーションというのは不可避なものでしょうか?」という問いかけを行いましたが、その回答としてGemini 1.5の回答が一番親切な回答である気がしますが、同時にハルシネーションも他の生成AIより多い気がするので、Gemini 1.5を利用する場合は、「G」ボタンを活用しながら利用するのがよさそうです。

以上、今回はGemini 1.5のハルシネーション対策について確認しました。

本日はここまでです。

おわり

- 投稿タグ

- Gemini 1.5, ハルシネーション