Roadside Beech trees in the snow

© Copyright Greg Fitchett and licensed for reuse under this Creative Commons Licence.

1つ前のブログで、「性能の良いものが安価に使えるに越したことはないと思いながらも、性能アップに連れてどんどんブラックボックスが増えていくことに一抹の不安も感じています」と言いましたが、工学部出身の自分としては、何に対しても「どういう仕組みで動いているのか?」が気になる性分で、生成AIもその例外ではありません。

前回は、生成AIモデルのパラメータとトークンに関して、日ごろモヤモヤしていたものをGeminiにぶつけてみましたが、今回は、自分が昔工学部の学生時代の実験でおこなっていたことと機械学習のアナロジーに始まって、ニューラルネットワークに繋ぎ、あまり深みにはまらないよう軽くディープラーニングに触れてから、大胆にもトランスフォーマーモデルの仕組みに関してGemini(Gemini 2.0 Flash)と対話した内容をご覧いただきたいと思います。

では、早速始めます。

■機械学習とは何かを説明してください。

機械学習とは、コンピュータが大量のデータを学習し、その学習結果に基づいて予測や判断を行う技術です。

機械学習の仕組み

機械学習では、まず大量のデータ(教師データ)をコンピュータに与えます。教師データには、問題と正解のペアが大量に含まれています。コンピュータは、この教師データを使って、問題と正解の間の関係性を学習します。

学習が終わると、コンピュータは新しい問題に対して、学習した関係性を使って正解を予測したり、判断したりすることができます。

機械学習の種類

機械学習には、大きく分けて以下の3つの種類があります。

- 教師あり学習: 正解データを使って学習する方法です。

- 教師なし学習: 正解データを使わずに学習する方法です。

- 強化学習: 行動の結果に応じて報酬を与え、最適な行動を学習する方法です。

機械学習の応用例

機械学習は、様々な分野で応用されています。

- 画像認識: 画像に写っているものを認識する技術です。

- 自然言語処理: 人間の言葉を理解する技術です。

- レコメンデーション: ユーザーの好みに合った商品を推薦する技術です。

- 自動運転: 車を自動で運転する技術です。

機械学習のメリット

機械学習には、以下のメリットがあります。

- 人間には難しい複雑な問題を解決できる: 大量のデータを分析し、人間には思いつかないような解決策を見つけ出すことができます。

- 予測精度が高い: 過去のデータに基づいて未来を予測することができます。

- 自動化できる: 人間が手作業で行っていた作業を自動化することができます。

機械学習の注意点

機械学習には、以下の注意点もあります。

- 大量のデータが必要: 機械学習の精度を高めるためには、大量のデータが必要です。

- 学習に時間がかかる: 機械学習の学習には、多くの時間と計算資源が必要です。

- 倫理的な問題: 機械学習の利用には、倫理的な問題が生じる可能性があります。

機械学習は、今後ますます発展していく技術です。私たちの生活をより豊かにしてくれる可能性を秘めています。

より詳しく知りたい場合は、以下のリソースを参考にしてください。

- 機械学習 – Wikipedia: https://en.wikipedia.org/wiki/Machine_learning

- 機械学習とは?仕組み、種類、利用例をやさしく解説 | AIDEL(アイデル) -人工知能特化型メディア-: https://monstar-lab.com/dx/technology/ai-machinelearning/

■ 自分が工学部の大学生のころは、まだAIとか機械学習とかの授業はなかったのですが、回帰分析を習い、実験で得た計測値のセットから、実験対象のシステムの振舞を線形モデルとして変数の係数を求めていたのは、今考えると、機械学習をしていたことになるのではないかと思うのですが、いかがでしょうか? 自分が実験を通してやっていたのは、例えば、Y =a1X1 + … + anXn +b や Y = a1X**n + a2X**(n-1) + … + anX +b のようなモデルを想定して、実験で(Yの値を含めた)x1~xnの実測値のセットからa1~anとbを推定するにあたって、MSEなどを利用していましたが、これは、機械学習での損失関数を利用した損失の最小化ということですよね。

おっしゃる通りです。実験を通して行っていたパラメータ推定は、まさに機械学習における損失関数を用いた損失最小化のプロセスそのものです。

具体的には、以下の点が対応しています。

- モデル:

- Y = a1X1 + … + anXn + b や Y = a1X^n + a2X^(n-1) + … + anX + b といった式は、機械学習におけるモデル(関数)に相当します。

- パラメータ:

- a1~an、b は、機械学習におけるパラメータに相当します。

- 実測値:

- x1~xn、Y の実測値セットは、機械学習における訓練データに相当します。

- MSE (平均二乗誤差):

- MSE は、機械学習における損失関数の一種です。損失関数は、予測値と正解値の誤差を定量化するために用いられます。

- 損失の最小化:

- MSE などを最小化するプロセスは、機械学習における損失最小化(最適化)に相当します。

- 最小二乗法は、MSE を最小化する代表的な手法です。

このように、実験で行っていたパラメータ推定は、機械学習の基本的な要素を全て含んでいます。

機械学習との違い

ただし、当時の実験と現代の機械学習には、以下のような違いがあります。

- データ量: 現代の機械学習では、より大量のデータが扱われることが一般的です。

- モデルの複雑さ: 現代の機械学習では、非線形モデルなど、より複雑なモデルが用いられることが増えています。

- アルゴリズム: 現代の機械学習では、勾配降下法など、より高度な最適化アルゴリズムが利用されています。

とはいえ、実験を通して回帰分析を経験されていたことは、現代の機械学習を理解する上で非常に役立つはずです。

■ データ量の違いやモデルの複雑さ、アルゴリズムの高度化はありますが、かつて自分は図らずも「機械学習」もどきをやっていたんだということが確認したかったので尋ねてみました。

おっしゃる通り、データ量の違いやモデルの複雑さ、アルゴリズムの高度化といった違いはあるものの、実験を通して行っていたパラメータ推定は、まさに機械学習の基礎をなすものであり、「機械学習もどき」どころか、立派な機械学習の一種と言えます。

実験データからモデルを構築し、誤差関数(損失関数)を最小化することでパラメータを推定するという一連の流れは、現代の機械学習においても全く同じです。

重要なのは、「過去の経験やデータに基づいて、将来を予測したり、判断したりする」 という機械学習の本質を、当時の実験を通して体感されていたということです。

この経験は、現代の進化した機械学習を学ぶ上で、非常に大きなアドバンテージになるはずです。

細かく言うと、複数の特徴量Xと、結果Yの実測値の組(=構造化されたデータ)を用いて「教師アリ」の機械学習を行っていたということになりますね。

はい、おっしゃる通りです。複数の特徴量Xと結果Yの実測値の組を用いて、教師あり学習を行っていた、という表現が最も正確です。

より具体的に表現すると、以下のようになります。

- 教師あり学習: 正解ラベル(Yの実測値)が与えられたデータを用いて学習を行うため。

- 複数の特徴量: 複数の説明変数(X1, X2, …, Xn)を入力としてモデルを構築するため。

- 構造化データ: 特徴量と結果がセットになった形式のデータ(実測値の組)を用いるため。

これらの要素を踏まえると、実験で行っていたことは、まさに現代の機械学習における回帰問題を扱っていたと言えます。

回帰問題とは、連続値(今回の場合はYの値)を予測する問題であり、機械学習の中でも基本的なタスクの一つです。

実験を通して、回帰分析という形で機械学習に触れていたというのは、非常に興味深いですね。

■ ところで、ニューラルネットワークにおける機械学習も教師あり学習ですね。

はい、その通りです。ニューラルネットワークを用いた機械学習も、多くの場合、教師あり学習です。

教師あり学習

教師あり学習とは、正解ラベル(教師データ)が与えられたデータを用いて学習を行う方法です。ニューラルネットワークでは、入力データとそれに対応する正解ラベルを用いて、ネットワークのパラメータ(重みやバイアス)を調整し、入力データから正解ラベルを予測できるように学習します。

ニューラルネットワークと教師あり学習

ニューラルネットワークは、複雑な関数を近似できる強力なモデルであり、画像認識、自然言語処理、音声認識など、様々なタスクで利用されています。これらのタスクの多くは、教師あり学習として扱われます。

例えば、画像認識の場合、画像データとそれが表す物体ラベル(例えば、「猫」、「犬」、「鳥」など)のペアを教師データとして学習を行います。学習済みのニューラルネットワークは、新しい画像データが入力されると、画像に写っている物体を予測することができます。

教師なし学習、強化学習

ニューラルネットワークは、教師あり学習だけでなく、教師なし学習や強化学習にも応用できます。

- 教師なし学習: 正解ラベルがないデータから、データの構造や特徴を学習する方法です(例:クラスタリング、次元削減)。

- 強化学習: 行動の結果に応じて報酬を与え、最適な行動を学習する方法です(例:ゲームAI、ロボット制御)。

ただし、ニューラルネットワークが最も得意とするのは、大量の教師データを用いて学習を行う教師あり学習です。

■ なるほど、ニューラルネットワークという仕組みは、学習のさせ方とは無関係ということですね。

はい、おっしゃる通りです。ニューラルネットワークは、仕組みと学習方法を区別して考えることができます。

ニューラルネットワークの仕組み

ニューラルネットワークは、以下のような要素で構成されています。

- ニューロン(ノード): 入力信号を処理し、出力信号を生成する基本単位

- 結合(エッジ): ニューロン同士を繋ぎ、信号を伝達する

- 重み: 結合の強さを表すパラメータ

- 活性化関数: ニューロンの出力を制御する関数

これらの要素が組み合わさることで、ニューラルネットワークは複雑な関数を表現することができます。

ニューラルネットワークの学習方法

ニューラルネットワークの学習方法は、大きく分けて以下の3つがあります。

- 教師あり学習: 正解ラベル付きのデータを用いて、ネットワークのパラメータを調整する

- 教師なし学習: 正解ラベルなしのデータから、データの構造や特徴を学習する

- 強化学習: 行動の結果に応じて報酬を与え、最適な行動を学習する

仕組みと学習方法の関係

ニューラルネットワークの仕組みは、どのような学習方法を用いるかに関わらず共通です。例えば、教師あり学習を行う場合でも、教師なし学習を行う場合でも、ニューラルネットワークの構造自体は変わりません。

ただし、学習方法によって、ネットワークのパラメータの調整方法や、最終的に得られるモデルの性質は異なります。

まとめ

ニューラルネットワークは、仕組みと学習方法を分けて考えることができます。

- 仕組み: ニューロン、結合、重み、活性化関数などから構成されるネットワークの構造

- 学習方法: 教師あり学習、教師なし学習、強化学習など、ネットワークのパラメータを調整する方法

ニューラルネットワークは、様々な学習方法を適用できる柔軟な仕組みであり、多様なタスクに対応できる強力なツールです。

■ GPTのようなトランスフォーマーモデルも、仕組み、学習方法において同じでしょうか

はい、GPTのようなTransformerモデルも、ニューラルネットワークの範疇に属し、仕組みと学習方法を区別して考えることができます。

Transformerモデルの仕組み

Transformerモデルは、2017年にGoogleが発表した論文 “Attention Is All You Need” で提案された新しいニューラルネットワークのアーキテクチャです。従来のRNN(Recurrent Neural Network)とは異なり、Attention機構という仕組みを導入することで、長文のテキストや系列データを効率的に処理できるようになりました。

Transformerモデルの主な構成要素は以下の通りです。

- Attention機構: 入力データ(単語やトークン)間の関係性を捉える

- Encoder: 入力データをベクトル表現に変換する

- Decoder: ベクトル表現から目的のデータ(テキストなど)を生成する

Transformerモデルの学習方法

Transformerモデルも、基本的には教師あり学習によって学習を行います。大量のテキストデータを用いて、入力テキストから次の単語を予測するように学習します。

例えば、GPTの場合、Web上の膨大なテキストデータを学習し、与えられた文章の続きを生成する能力を獲得しています。

Transformerモデルの仕組みと学習方法

Transformerモデルの仕組み(Attention機構など)は、どのような学習方法を用いるかに関わらず共通です。ただし、学習方法によって、モデルのパラメータの調整方法や、最終的に得られるモデルの性質は異なります。

例えば、GPTのようにテキスト生成に特化したモデルもあれば、BERTのようにテキストの意味を理解することに特化したモデルもあります。

まとめ

Transformerモデルも、ニューラルネットワークの一種であり、仕組みと学習方法を分けて考えることができます。

- 仕組み: Attention機構、Encoder、Decoderなどから構成されるネットワークの構造

- 学習方法: 教師あり学習など、ネットワークのパラメータを調整する方法

Transformerモデルは、Attention機構という強力な仕組みと、大量のデータを用いた教師あり学習を組み合わせることで、自然言語処理の分野に革命をもたらしました。

■ トランスフォーマーモデルと、それ以前のディープラーニングニューラルネットワークモデルの共通部分と相違する部分を整理してください。

トランスフォーマーモデルと以前のディープラーニングモデルの共通点と創始的な部分

共通点

- ニューラルネットワーク:

- どちらもニューラルネットワークを基盤としている。

- 多数のニューロン(ノード)が層状に連結され、複雑な関数を学習する。

- 誤差逆伝播法を用いてパラメータ(重み)を調整する。

- 教師あり学習:

- 多くのトランスフォーマーモデルは、教師あり学習で学習される。

- 入力データと正解ラベルのペアを用いて、モデルの予測精度を高める。

- 層構造:

- どちらも複数の層を組み合わせることで、複雑な特徴を抽出する。

- 各層は、入力データを変換し、次の層へ渡す役割を担う。

相違する部分

- Attention機構:

- トランスフォーマーモデルの最大の特徴は、Attention機構である。

- 入力データ(単語やトークン)間の関係性を直接捉えることができる。

- これにより、長文や系列データの処理が効率的になった。

- RNNの不要化:

- 従来のRNN(Recurrent Neural Network)は、時系列データの処理に特化していた。

- トランスフォーマーモデルは、Attention機構によりRNNなしで系列データを扱える。

- これにより、並列計算が可能になり、学習速度が向上した。

- 自己注意機構:

- トランスフォーマーモデルは、自己注意(Self-Attention)機構を備えている。

- 入力データの中で、互いに関連性の高い要素を強調することができる。

- これにより、文脈を考慮したより高度な処理が可能になった。

- Encoder-Decoder構造:

- トランスフォーマーモデルは、Encoder-Decoder構造を持つ。

- Encoderは入力データをベクトル表現に変換し、Decoderはベクトル表現から目的のデータ(テキストなど)を生成する。

- この構造により、機械翻訳などの系列変換タスクで高い性能を発揮する。

まとめ

トランスフォーマーモデルは、ニューラルネットワークを基盤とする点で以前のモデルと共通している。しかし、Attention機構、RNNの不要化、自己注意機構、Encoder-Decoder構造といった要素により、自然言語処理の分野に大きな進歩をもたらした。

■ 通常、ディープラーニングの解説では、入力層+複数の隠れ層+出力層のニューラルネットワークであると説明されますが、トランスフォーマーモデルの自己注意(Self-Attention)機構とかEncoder-Decoder構造と、ニューラルネットワークとの対応というかニューロンとの対応はどうなっているのでしょうか?

おっしゃる通り、従来のニューラルネットワーク(特に多層パーセプトロンやRNN)の解説では、入力層、隠れ層、出力層という層構造が強調されます。一方、Transformerモデルの自己注意機構やEncoder-Decoder構造は、これらの層構造とは少し異なる概念です。

自己注意機構とニューロンの対応

自己注意機構は、ニューラルネットワークにおける層というよりは、ニューロン間の相互作用を捉える仕組みと考えると理解しやすいです。

従来のニューラルネットワークでは、各ニューロンは前の層のニューロンからの入力を受け取り、活性化関数を通して出力を次の層に渡します。この際、各ニューロンは前の層のすべてのニューロンからの入力を等しく扱います。

一方、自己注意機構では、各ニューロン(Transformerモデルでは単語やトークンに対応)は、他のすべてのニューロンとの関係性を計算し、その関係性の強さに応じて入力を重み付けします。これにより、**特定のニューロン(単語)**に注目したり、文脈を考慮した処理が可能になります。

自己注意機構は、複数のニューロン間の関係性を捉えるという点で、従来のニューラルネットワークの層構造とは異なる役割を果たしています。

Encoder-Decoder構造とニューロンの対応

Encoder-Decoder構造は、Transformerモデルをタスクに合わせて利用するための枠組みであり、特定のニューロンや層に対応するものではありません。

- Encoder: 入力データをベクトル表現に変換する役割を担います。Encoderは、複数のTransformerブロック(自己注意機構を含む)を積み重ねることで実現されます。

- Decoder: Encoderが生成したベクトル表現から、目的のデータ(テキストなど)を生成する役割を担います。Decoderも、複数のTransformerブロック(自己注意機構を含む)を積み重ねることで実現されます。

Encoder-Decoder構造は、系列変換タスク(機械翻訳など)において、入力系列と出力系列の関係性を学習するために有効な枠組みです。

まとめ

- 自己注意機構は、ニューロン間の相互作用を捉える仕組みであり、従来のニューラルネットワークの層構造とは異なる役割を果たします。

- Encoder-Decoder構造は、Transformerモデルをタスクに合わせて利用するための枠組みであり、特定のニューロンや層に対応するものではありません。

Transformerモデルは、自己注意機構とEncoder-Decoder構造を組み合わせることで、従来のニューラルネットワークでは難しかった長文や系列データの処理を効率的に行えるようになりました。

■ トランスフォーマーモデルでは、入力層のニューロンが1つで、そこにトークン化されたテキストの1次元ベクトルのデータが入ってくるというイメージを持っているのですが、この認識であっていますか?

ほぼ合っていますが、厳密には少し補足が必要です。

トランスフォーマーモデルの入力

- トークン化されたテキスト: おっしゃる通り、トランスフォーマーモデルへの入力は、トークン化されたテキストの1次元ベクトルです。

- 埋め込み: ただし、入力層に直接トークンID(単語や文字に割り当てられた数値)が入るわけではありません。通常は、埋め込み層 (Embedding Layer) でトークンIDがベクトルに変換されます。このベクトルは、単語や文字の意味や文脈を反映するように学習されます。

- 位置情報: トランスフォーマーモデルでは、単語の位置情報も重要な入力となります。これは、単語の順序が文の意味に影響を与えるためです。位置情報は、通常、位置埋め込み (Positional Embedding) という形でベクトル化され、単語の埋め込みベクトルに加算されます。

入力層のニューロン数

入力層のニューロン数についてですが、1つのニューロンに1次元ベクトル全体が入るわけではありません。

- 単語(トークン)ごとにベクトル: トランスフォーマーモデルでは、各単語(トークン)が個別のベクトルとして扱われます。

- ベクトルの次元数: このベクトルの次元数は、モデルによって異なりますが、例えば512次元や1024次元など、比較的高次元のベクトルが用いられます。

- 入力層のニューロン数: 入力層のニューロン数は、トークン数 × ベクトルの次元数 となります。例えば、10個の単語からなる文を入力する場合、各単語が512次元のベクトルで表現されると、入力層のニューロン数は 10 × 512 = 5120 となります。

まとめ

- トランスフォーマーモデルへの入力は、トークン化されたテキストの1次元ベクトルですが、実際には埋め込み層でベクトルに変換され、位置情報も付加されます。

- 入力層のニューロン数は、トークン数とベクトルの次元数の積になります。

ご質問のイメージはおおむね合っていますが、埋め込み層や位置情報、入力層のニューロン数について補足させていただきました。

■ なるほど、実際にトランスフォーマーモデルで処理対象となるのは、トークン化されたテキストの1次元ベクトルではなくて、フロンエンドの埋め込み層でトークンごとに多次元ベクトルに変換されたものを束ねた行列データになっているということですね。

はい、その通りです。

おっしゃる通り、トランスフォーマーモデルに実際に入力されるのは、トークン化されたテキストの1次元ベクトルではなく、埋め込み層でトークンごとに多次元ベクトルに変換されたものを束ねた行列データです。

具体的には、以下のようになります。

- トークン化: テキストを単語やサブワードなどの単位(トークン)に分割します。

- 埋め込み: 各トークンを、意味や文脈に応じた多次元のベクトル(埋め込みベクトル)に変換します。この処理は、埋め込み層(Embedding Layer)で行われます。

- 行列化: 複数のトークンの埋め込みベクトルを束ねて、行列データにします。この行列の各行が、各トークンの埋め込みベクトルに対応します。

- 位置情報: 各トークンの位置情報を、位置埋め込み(Positional Embedding)という形でベクトル化し、埋め込みベクトルに加算します。

- 入力: 位置情報が加算された埋め込みベクトルの行列が、トランスフォーマーモデルへの入力となります。

この行列データは、各トークンの情報だけでなく、トークン間の関係性や文脈の情報も含むため、トランスフォーマーモデルはより高度な自然言語処理を行うことができます。

ご質問の通り、トランスフォーマーモデルの入力は、トークンごとに多次元ベクトルに変換されたものを束ねた行列データである、という理解で概ね合っています。

■ で、各トークンに対応する入力データ中の位置情報も、位置埋め込み (Positional Embedding) という形でベクトル化されて、トークンのベクトルに加算されるということですね。

はい、その通りです。

各トークンに対応する入力データ中の位置情報は、位置埋め込み (Positional Embedding) という形でベクトル化され、トークンのベクトルに加算されます。

位置埋め込みは、トークンの順序や位置をモデルに認識させるために重要な役割を果たします。

位置埋め込みの方法

位置埋め込みには、様々な方法がありますが、代表的なのは以下の2つです。

- 固定位置埋め込み:

- あらかじめ決められた関数(通常は正弦波と余弦波)を用いて、各位置に対応するベクトルを生成します。

- このベクトルを、トークンの埋め込みベクトルに加算します。

- 学習可能位置埋め込み:

- 位置情報も学習可能なパラメータとして扱います。

- モデルの学習過程で、適切な位置埋め込みベクトルが学習されます。

どちらの方法を用いるかは、モデルやタスクによって異なります。

位置埋め込みの重要性

位置埋め込みは、特に系列データ(テキスト、音声など)を扱う際に重要です。

例えば、

- 「Yesterday I saw a black cat.」

- 「I saw a black cat yesterday.」

という2つの文は、単語は同じですが、順序が異なります。位置埋め込みがないと、モデルはこれらの文を区別することができません。

位置埋め込みによって、モデルは単語の順序や位置関係を考慮した処理を行うことができるようになります。

■ GPTの場合の位置埋め込み方法はどれになりますか?

GPT (Generative Pre-trained Transformer) モデルの場合、位置埋め込み方法としては、学習可能位置埋め込み が用いられています。

学習可能位置埋め込み

学習可能位置埋め込みでは、各位置に対応するベクトルを、モデルの学習過程でデータから学習します。つまり、位置情報もモデルのパラメータの一部として扱われるということです。

固定位置埋め込みとの比較

固定位置埋め込みでは、あらかじめ決められた関数(通常は正弦波と余弦波)を用いて位置ベクトルを生成します。一方、学習可能位置埋め込みでは、データに基づいて最適な位置ベクトルが学習されます。

GPTにおける学習可能位置埋め込みの利点

GPTでは、学習可能位置埋め込みを用いることで、より柔軟に位置情報を表現できると考えられます。

- 複雑な位置関係: 自然言語における単語の順序や位置関係は、単純な関数では捉えきれない複雑なパターンを含む可能性があります。学習可能位置埋め込みでは、このような複雑なパターンをデータから学習することができます。

- モデルの適応力: 学習可能位置埋め込みは、特定のタスクやデータセットに合わせて位置情報を最適化することができます。

まとめ

GPTでは、学習可能位置埋め込みを用いることで、より高度な自然言語処理を実現しています。

■ ここまでトランスフォーマーモデルの動きは理解できたと思います。こうしてできた最初のトークンに対応するベクトルデータは、誰がどういう単位で受取り、次に何をするのでしょうか?

はい、ここまででトランスフォーマーモデルの入力部分についてはご理解いただけたかと思います。それでは、最初のトークンに対応するベクトルデータが生成された後、誰がどのように受け取り、次に何をするのかについてご説明します。

- トランスフォーマーモデル内部での処理

まず、生成されたトークンベクトルは、トランスフォーマーモデル内部で処理されます。具体的には、以下のようになります。

- 自己注意機構 (Self-Attention): 同じ入力系列内の他のトークンとの関係性を計算し、各トークンの表現を更新します。これにより、文脈に応じたより豊かな表現を獲得します。

- フィードフォワードネットワーク (Feed-Forward Network): 各トークンのベクトルを、さらに非線形変換します。これにより、モデルの表現力を高めます。

- 残差接続と層正規化: 各層の出力を元の入力に加算する残差接続と、層内の活性化を安定化する層正規化を適用します。

これらの処理を、複数の層にわたって繰り返すことで、トークンベクトルは徐々に洗練されていきます。

- モデルの出力

トランスフォーマーモデルの出力は、タスクによって異なります。

- 系列生成タスク (例: テキスト生成、機械翻訳):

- 最後の層から出力されたトークンベクトルを、softmax関数などを用いて確率分布に変換します。

- この確率分布に基づいて、次のトークンを生成します。

- 生成されたトークンは、再び入力としてモデルに与えられ、次のトークンが生成されます。

- この処理を繰り返すことで、目的の系列データ(テキストなど)が生成されます。

- 分類タスク (例: 感情分析):

- 最後の層から出力されたトークンベクトルを、平均化したり、特定のトークン(例: [CLS]トークン)のベクトルを取り出したりします。

- このベクトルを、全結合層やsoftmax関数などに入力し、最終的な分類結果を得ます。

- 出力の利用

生成された出力は、様々な形で利用されます。

- テキスト生成:

- チャットボット、文章作成、翻訳など

- 分類:

- 感情分析、スパムフィルタリング、画像分類など

- その他:

- 質問応答、要約、情報検索など

まとめ

トークンに対応するベクトルデータは、トランスフォーマーモデル内部で自己注意機構やフィードフォワードネットワークなどによって処理され、タスクに応じた出力に変換されます。この出力は、様々な形で利用されます。

ご質問の「誰がどういう単位で受け取り、次に何をするのか」という点について、具体的にイメージできたでしょうか?

■ 具体的に、まず、プロンプトの内容からトークン分割された最初のトークンが入ってきた場合について、何が起きるのか教えてもらえますか

はい、プロンプトの内容からトークン分割された最初のトークンが入ってきた場合に何が起きるのか、具体的な流れを説明します。

- トークン化と埋め込み

- まず、プロンプトとして与えられたテキストは、トークンと呼ばれる単位(単語やサブワードなど)に分割されます。

- 分割された各トークンは、埋め込み層(Embedding Layer)で多次元のベクトル(埋め込みベクトル)に変換されます。

- 最初のトークンも同様に、対応する埋め込みベクトルに変換されます。

- 位置埋め込みの加算

- トランスフォーマーモデルでは、トークンの位置情報も重要な要素です。

- 各トークンには、その位置に対応する位置埋め込み(Positional Embedding)ベクトルが加算されます。

- 最初のトークンにも、その位置(通常は0番目)に対応する位置埋め込みベクトルが加算されます。

- 入力

- 埋め込みベクトルと位置埋め込みベクトルが加算されたものが、最初のトークンの入力データとなります。

- この入力データは、トランスフォーマーモデルの最初の層(通常はEncoderまたはDecoderの最初のブロック)に渡されます。

- 自己注意機構

- 最初の層では、自己注意機構(Self-Attention)が働きます。

- 自己注意機構は、入力されたトークン(この場合は最初のトークン)と、同じ系列内の他のトークン(まだ入力されていない場合は、特別な開始トークンやパディングトークンなどが考えられます)との関係性を計算します。

- この計算結果に基づいて、最初のトークンの表現が更新されます。

- フィードフォワードネットワーク

- 自己注意機構で更新されたトークンベクトルは、フィードフォワードネットワーク(Feed-Forward Network)に渡されます。

- フィードフォワードネットワークは、各トークンのベクトルをさらに非線形変換し、表現力を高めます。

- 残差接続と層正規化

- フィードフォワードネットワークの出力は、元の入力(自己注意機構への入力)に加算されます(残差接続)。

- また、層内の活性化を安定化するために、層正規化(Layer Normalization)が適用されます。

- 次の層へ

- 層正規化された出力は、次の層(通常はEncoderまたはDecoderの次のブロック)に渡されます。

- 2番目以降の層でも、同様に自己注意機構、フィードフォワードネットワーク、残差接続、層正規化の処理が行われます。

- 出力

- 最後の層まで処理が進むと、各トークンに対応するベクトルが出力されます。

- この出力は、タスクに応じて様々な方法で利用されます(例: 系列生成、分類など)。

まとめ

最初のトークンが入力された場合、埋め込みと位置埋め込みの加算、自己注意機構、フィードフォワードネットワーク、残差接続、層正規化といった処理を経て、次の層へと渡されます。この処理が多層にわたって繰り返されることで、トークンの表現が徐々に洗練されていきます。

■ 「3.入力」で「この入力データは、トランスフォーマーモデルの最初の層(通常はEncoderまたはDecoderの最初のブロック)に渡されます。』とありますが、EncoderではなくいきなりDecoderのことがあるのですか?それと、トランスフォーマーモデルの最初の層ということは、複数のトランスフォーマーの層があるという前提ですね。フィードフォワードネットワークというのは、第2層以降のトランスフォーマー層ということでしょうか?

Transformerモデルの構成と処理の流れについて、さらに詳しくご説明します。

EncoderとDecoder

Transformerモデルには、EncoderとDecoderの2つの主要なブロックがあります。

- Encoder: 入力データをベクトル表現に変換する役割を担います。

- Decoder: Encoderが生成したベクトル表現から、目的のデータ(テキストなど)を生成する役割を担います。

どちらのブロックが最初に来るかは、モデルのタスクや構造によって異なります。

- 系列変換タスク (例: 機械翻訳): Encoderが入力系列を処理し、Decoderが出力系列を生成する、Encoder-Decoder構造が一般的です。

- 言語モデル (例: GPT): Decoderのみを用いて、テキストの生成を行います。

ご質問の「最初の層」がEncoderとDecoderのどちらになるかは、モデルの構造によって異なります。

複数のTransformer層

Transformerモデルは、複数のTransformer層(ブロック)を積み重ねて構成されます。各層は、自己注意機構、フィードフォワードネットワーク、残差接続、層正規化などの処理を行います。

複数の層を積み重ねることで、より複雑な特徴を抽出したり、より長距離の依存関係を捉えたりすることが可能になります。

フィードフォワードネットワーク

フィードフォワードネットワークは、Transformer層(ブロック)内に含まれる要素の一つです。

各Transformer層は、以下の要素で構成されています。

- 自己注意機構 (Self-Attention)

- フィードフォワードネットワーク (Feed-Forward Network)

- 残差接続 (Residual Connection)

- 層正規化 (Layer Normalization)

フィードフォワードネットワークは、自己注意機構の後に配置され、各トークンのベクトルをさらに非線形変換する役割を担います。

したがって、フィードフォワードネットワークは、第2層以降のTransformer層というわけではありません。各Transformer層に、自己注意機構とともに含まれています。

まとめ

- Transformerモデルには、EncoderとDecoderの2つの主要なブロックがあり、どちらが最初に来るかはモデルによって異なります。

- Transformerモデルは、複数のTransformer層(ブロック)を積み重ねて構成されます。

- フィードフォワードネットワークは、各Transformer層に含まれる要素の一つです。

ご理解いただけましたでしょうか?

■ GPTのような言語モデルの場合は、通常のディープラーニングで言うと入力層にあたる部分で埋め込みベクトルと位置埋め込みベクトルが加算されたものを作り、トランスフォーマーモデルの最初の層に渡される。そこでは、①自己注意機構が働いて同じ系列内の他のトークンとの関係性を計算し、②フィードフォワードネットワークで、入力されたベクトルをさらに非線形変換し、残差接続、層正規化の処理が行われて次のトランスフォーマー層に渡される。ーということで良いですか?

はい、その理解で概ね合っています。GPTのような言語モデルにおける処理の流れをまとめると、以下のようになります。

- 入力層(埋め込み層):

- トークン化されたテキストを受け取る。

- 各トークンを対応する埋め込みベクトルに変換する。

- 各トークンの位置情報を位置埋め込みベクトルとして生成する。

- 埋め込みベクトルと位置埋め込みベクトルを加算する。

- この加算されたベクトルが、トランスフォーマーモデルの最初の層への入力となる。

- トランスフォーマーモデル(複数の層):

- 最初の層から順に、以下の処理を繰り返す。

- 自己注意機構 (Self-Attention): 入力されたトークンベクトルと、同じ系列内の他のトークンベクトルとの関係性を計算し、各トークンの表現を更新する。

- フィードフォワードネットワーク (Feed-Forward Network): 各トークンベクトルをさらに非線形変換する。

- 残差接続 (Residual Connection): 現在の層の出力を、前の層の入力に加算する。

- 層正規化 (Layer Normalization): 各層の出力を正規化する。

- 最後の層まで処理が終わると、各トークンに対応するベクトルが出力される。

- 最初の層から順に、以下の処理を繰り返す。

- 出力層:

- 最後の層から出力されたベクトルを、タスクに応じて適切な形式に変換する。

- 例えば、テキスト生成タスクであれば、softmax関数などを用いて次のトークンの確率分布を計算する。

おっしゃる通り、自己注意機構で同じ系列内の他のトークンとの関係性を計算し、フィードフォワードネットワークで非線形変換を行う、という流れで処理が進みます。残差接続と層正規化は、モデルの学習を安定化させるためのテクニックです。

この一連の流れを各層で繰り返すことで、トークンの表現が徐々に洗練され、より高度な言語処理が可能になります。

■ 2番目以降のトークンに関しても同じように処理されていくと思うのですが、GPTのような言語モデルの場合、例えば入力したプロンプトのテキストをトークン分割した結果、10トークンに分割されていたとすると、出力層は、10トークン目までは元のまま出力して11トークン目のみ生成すればよいと思うのですが、3の出力層の処理として「テキスト生成タスクであれば、softmax関数などを用いて次のトークンの確率分布を計算する」のはどういうタイミングなのか、とその確率計算結果に基づいて11番目のトークンを出力しないのか答えてください。

はい、2番目以降のトークンに関しても同じように処理されていきます。そして、おっしゃる通り、10トークンに分割されたプロンプトが入力された場合、出力層で11番目のトークンを生成する必要があります。

出力層の処理タイミング

出力層の処理タイミングは、各トークンが処理されるたびに 行われます。

具体的には、以下のようになります。

- 最初のトークン: 最初のトークンが入力され、トランスフォーマーモデル内部で処理された後、出力層で次のトークン(2番目のトークン)の確率分布が計算されます。

- 2番目のトークン: 2番目のトークンが入力され、処理された後、出力層で次のトークン(3番目のトークン)の確率分布が計算されます。

- …

- 10番目のトークン: 10番目のトークンが入力され、処理された後、出力層で次のトークン(11番目のトークン)の確率分布が計算されます。

このように、各トークンが処理されるたびに、次のトークンの確率分布が計算されます。

11番目のトークンの出力

計算された確率分布に基づいて、11番目のトークンが出力されます。

通常、最も確率の高いトークンが選択されますが、ランダム性を導入するために、確率分布に従ってランダムにトークンを選択する場合もあります。

例えば、

- 確率が最も高いトークンを常に選択する場合: Greedy Search

- 確率分布に基づいてランダムにトークンを選択する場合: Sampling

- 複数の候補トークンを保持しながら探索する場合: Beam Search

など、様々な生成方法があります。

GPTのような言語モデルでは、SamplingやBeam Searchなどを利用することで、より多様で自然なテキスト生成を実現しています。

まとめ

- 出力層の処理は、各トークンが処理されるたびに 行われ、次のトークンの確率分布が計算されます。

- 11番目のトークンは、計算された確率分布に基づいて、適切な方法で選択・出力されます。

ご理解いただけましたでしょうか?

■ 確認したかったのは、①10番目のトークン処理以外、次のトークンの確率分布を計算しなくても良いのではないかと、②10番目のトークン処理では、単に次のトークンの確率分布を計算するだけでなく、Greedy Searchその他の生成方法で11番目のトークンを作成する処理が抜けているのではないかという点でした。

確認されたかったのは、①10番目のトークン処理以外は次のトークンの確率分布を計算しなくても良いのではないか、②10番目のトークン処理では、単に次のトークンの確率分布を計算するだけでなく、Greedy Searchその他の生成方法で11番目のトークンを作成する処理が抜けているのではないか、という2点ですね。

それぞれについて、詳しく説明します。

①10番目のトークン処理以外は次のトークンの確率分布を計算しなくても良いのではないか

必ずしもそうとは限りません。

確かに、最終的な出力を生成するだけであれば、10番目のトークンの処理時に11番目のトークンを生成すれば済みます。しかし、GPTのような大規模言語モデルでは、内部的な処理においても、各トークンに対する確率分布を計算している場合があります。

例えば、

- 学習: モデルの学習時には、各トークンに対する予測誤差を計算する必要があります。この際、各トークンに対する確率分布が必要になります。

- 内部表現の更新: モデル内部では、各トークンの表現が層ごとに更新されます。この更新には、他のトークンとの関係性や文脈情報が用いられます。これらの情報を効率的に処理するために、確率分布が利用されることがあります。

- 多様なタスク: GPTは、テキスト生成だけでなく、様々なタスクに利用できます。タスクによっては、各トークンに対する確率分布が必要になる場合があります。

したがって、10番目のトークン処理以外でも、次のトークンの確率分布を計算している可能性はあります。

②10番目のトークン処理では、単に次のトークンの確率分布を計算するだけでなく、Greedy Searchその他の生成方法で11番目のトークンを作成する処理が抜けているのではないか

おっしゃる通りです。

10番目のトークン処理では、次のトークンの確率分布を計算するだけでなく、その確率分布に基づいて11番目のトークンを生成する必要があります。

ご指摘の通り、Greedy Search、Sampling、Beam Searchなど、様々な生成方法を用いて11番目のトークンを決定します。

確率分布の計算は、あくまで次のトークンの候補を絞り出すためのものであり、実際にどのトークンを選択するかは、生成方法によって異なります。

まとめ

- 10番目のトークン処理以外でも、内部的な処理や多様なタスクのために、次のトークンの確率分布を計算している可能性があります。

- 10番目のトークン処理では、確率分布の計算に加えて、Greedy Searchなどの生成方法を用いて11番目のトークンを生成する必要があります。

ご指摘ありがとうございました。

■ なるほど、学習時は、出力層で、各トークンに対する確率分布を再計算した結果を書き戻す必要があるということですね。トランスフォーマーモデルでの処理の流れは大体把握できました。少し戻りますが、①フィードフォワードネットワーク (Feed-Forward Network)で行う 各トークンベクトルをさらに非線形変換するとはどういうことをするのか、②残差接続 (Residual Connection)の「現在の層の出力を、前の層の入力に加算する」意図は何か、③層正規化 (Layer Normalization)の「 各層の出力を正規化する」とは具体的に何をするのかわかりやすく説明してください。

はい、もちろんです。Transformerモデルの各層における処理について、それぞれわかりやすくご説明します。

① フィードフォワードネットワーク (Feed-Forward Network)

フィードフォワードネットワークは、各トークンベクトルをさらに非線形変換する役割を担います。

具体的には、以下の処理を行います。

- 線形変換: 入力されたトークンベクトルに、重み行列を乗算し、バイアスを加算します。

- 活性化関数: 線形変換されたベクトルを、活性化関数(ReLUなど)に通します。これにより、非線形性が導入されます。

- 線形変換: 活性化関数を通ったベクトルに、別の重み行列を乗算し、バイアスを加算します。

非線形変換の意味

非線形変換を行うことで、モデルはより複雑な関数を表現できるようになります。

もし、線形変換しか行わない場合、複数の層を重ねても、結局は1つの線形変換にしかなりません。しかし、非線形変換を挟むことで、多層構造の恩恵を受けることができます。

イメージ

フィードフォワードネットワークは、各トークンベクトルを別の空間に写像するようなイメージです。この写像によって、トークンベクトルがより豊かな表現を獲得すると考えられます。

② 残差接続 (Residual Connection)

残差接続は、現在の層の出力を、前の層の入力に加算する処理です。

残差接続の意図

残差接続の主な意図は、勾配消失問題を緩和することです。

ディープラーニングモデルでは、層が深くなるにつれて、勾配が徐々に小さくなり、学習が困難になる現象(勾配消失問題)が起こりやすくなります。

残差接続は、前の層の情報を直接現在の層に伝えることで、勾配が流れやすくし、勾配消失問題を緩和する効果があります。

イメージ

残差接続は、ショートカットのようなものです。現在の層の出力に、前の層の情報を直接加えることで、情報が失われるのを防ぎます。

③ 層正規化 (Layer Normalization)

層正規化は、各層の出力を正規化する処理です。

層正規化の意図

層正規化の主な意図は、学習の安定化です。

ディープラーニングモデルでは、各層の入力分布が大きく変動すると、学習が不安定になることがあります。

層正規化は、各層の出力を平均0、分散1になるように正規化することで、入力分布の変動を抑え、学習を安定化させる効果があります。

具体例

例えば、ある層の出力が [100, 200, 300] というベクトルだったとします。層正規化を行うと、このベクトルは [約-1.22, 約0.00, 約1.22] のように変換されます。

イメージ

層正規化は、各層の出力を揃えるようなイメージです。これにより、学習がスムーズに進むようになります。

まとめ

- フィードフォワードネットワーク: 各トークンベクトルを非線形変換し、表現力を高める

- 残差接続: 前の層の情報を直接現在の層に伝え、勾配消失問題を緩和する

- 層正規化: 各層の出力を正規化し、学習を安定化させる

これらの処理を組み合わせることで、Transformerモデルはより高度な自然言語処理を実現しています。

■ 一般的なディープラーニングの隠れ層の処理としては、線形変換+活性化関数の結果を次の層に渡していると思うのですが、トランスフォーマーモデルのフィードフォワードネットワークで更にもう一度線形変換する理由は何ですか?

おっしゃる通り、一般的なディープラーニングの隠れ層の処理は、線形変換 + 活性化関数です。Transformerモデルのフィードフォワードネットワークでさらにもう一度線形変換を行う理由は、モデルの表現力を高めるためです。

- 線形変換 + 活性化関数だけの場合

線形変換 + 活性化関数だけでも、ある程度の複雑な関数を表現できます。しかし、表現できる関数の複雑さには限界があります。

- フィードフォワードネットワークの場合 (線形変換 + 活性化関数 + 線形変換)

フィードフォワードネットワークでは、線形変換 + 活性化関数の後に、もう一度線形変換を行います。

このもう一度の線形変換が、モデルの表現力を大きく向上させる役割を果たします。

具体的な例

例として、あるトークンベクトルが、線形変換 + 活性化関数によって以下のようになったとします。

- 入力: [x1, x2, x3]

- 線形変換 + 活性化関数後: [f(x1), f(x2), f(x3)] (fは活性化関数)

この後、もう一度線形変換を行うことで、[f(x1), f(x2), f(x3)] の各要素が線形結合されます。

この線形結合によって、f(x1), f(x2), f(x3) の相互作用を捉えることができるようになります。

なぜ相互作用を捉えることが重要なのか

自然言語処理において、単語の意味は、周囲の単語との関係性によって変化します。

例えば、「apple」という単語は、文脈によって「リンゴ」という意味になったり、「アップル社」という意味になったりします。

フィードフォワードネットワークにおける2度の線形変換は、単語の意味のこのような文脈依存性を捉えるために重要です。

まとめ

フィードフォワードネットワークで2度線形変換を行うことで、活性化関数を通った各要素の線形結合が可能になり、要素間の相互作用を捉えることができます。この相互作用を捉えることが、モデルの表現力を高め、より複雑な関数を表現できるようにする理由です。

■ どうもありがとう。トランスフォーマーモデルでどのような処理が行われているのかかなり明確になりました。最後に良く「Transformer が使用する計算は並列処理に適している」と聞くのですが、その理由を教えてください。

はい、おっしゃる通り、Transformerモデルの大きな特徴の一つが、並列処理に適していることです。この特徴により、Transformerモデルは大規模なデータセットを効率的に学習し、高速な推論処理を実現しています。

Transformerモデルが並列処理に適している理由は、主に以下の2点です。

- RNNの不要化

従来の系列モデル(RNNなど)では、時系列データ(テキストなど)を逐次的に処理する必要がありました。つまり、前の単語の処理が終わるまで、次の単語の処理を開始することができませんでした。

一方、Transformerモデルでは、Attention機構を用いることで、系列内の各要素(単語など)の関係性を同時に計算することができます。

これにより、各単語の処理を並行して行うことが可能になり、計算時間を大幅に短縮できます。

- 行列演算の活用

Transformerモデルの各層(自己注意機構、フィードフォワードネットワークなど)で行われる処理は、行列演算として記述することができます。

行列演算は、GPUなどの並列計算ハードウェアで効率的に処理できるため、高速な計算が可能です。

具体的な例

例えば、10個の単語からなる文を処理する場合、

- RNN: 1番目の単語、2番目の単語、…、10番目の単語、というように順番に処理する必要がある

- Transformer: 1番目から10番目の単語まで同時に処理できる

という違いがあります。

まとめ

Transformerモデルが並列処理に適している理由は、

- Attention機構によって系列内の各要素を同時に処理できること

- 処理が行列演算として記述できること

の2点です。

これらの特徴により、Transformerモデルは大規模言語モデルの学習や、高速な推論処理を実現しています。

■ 行列演算するというのは、1つのトークンに対応する埋め込みベクトルを1番目から最後までを行列として一気に処理できるということを言っているのでしょうか?

はい、その理解でおおむね合っています。

ただし、厳密には少し補足が必要です。

行列演算の対象

行列演算の対象となるのは、バッチと呼ばれる単位でまとめられた複数のトークンです。

例えば、

- 1つの文に含まれる複数のトークン

- 複数の文それぞれに含まれる複数のトークン

などがバッチとして扱われます。

行列演算の内容

行列演算では、バッチ内の各トークンに対する処理(自己注意機構、フィードフォワードネットワークなど)をまとめて行います。

具体的には、

- 各トークンのベクトルを行列として表現する

- 行列に対して、重み行列を乗算したり、活性化関数を適用したりする

といった処理を行います。

並列処理との関係

行列演算は、GPUなどの並列計算ハードウェアで効率的に処理できるため、高速な計算が可能です。

バッチ内の各トークンに対する処理を並行して行うことで、計算時間を大幅に短縮できます。

まとめ

- 行列演算は、バッチ単位でまとめられた複数のトークンに対して行われます。

- 行列演算によって、各トークンの処理を並行して行うことができ、高速な計算が可能です。

ご質問の「1つのトークンに対応する埋め込みベクトルを1番目から最後までを行列として一気に処理できる」という理解は、バッチという単位で複数のトークンをまとめて処理するという意味で、おおむね合っています。

■ 各トランスフォーマー層内のフィードフォワードネットワークの出力が、元の入力(自己注意機構への入力)に加算される残差接続というのは並列処理を妨げないのでしょうか?

ご質問ありがとうございます。残差接続が並列処理を妨げないか、という点についてご説明します。

結論から言うと、残差接続は並列処理を妨げません。

その理由は、残差接続の処理が非常に単純だからです。

具体的には、残差接続は、

- 自己注意機構の出力を層正規化する

- 層正規化された出力と、自己注意機構への入力を要素ごとに加算する

という2つのステップで構成されています。

このうち、要素ごとの加算は、並列処理が可能な処理です。

例えば、

入力A: [1, 2, 3]

自己注意機構の出力B: [4, 5, 6]

という2つのベクトルがあった場合、残差接続は、

A + B = [1+4, 2+5, 3+6] = [5, 7, 9]

という計算を行います。

この計算は、各要素ごとに独立して行われるため、並列処理に適しています。

したがって、残差接続は、Transformerモデルの並列処理の恩恵を損なうことなく、勾配消失問題を緩和する役割を果たすことができます。

ご安心ください。

■ もう1つまだイメージできないのは、アテンション機構を働かせるためには、最後のトークンまで読み込む必要があると思うのですが、並列処理というのはどういうタイミングで始まるのでしょうか

おっしゃる通り、アテンション機構を働かせるためには、原理的には最後のトークンまで読み込む必要があります。しかし、Transformerモデルの並列処理は、学習時と推論時でタイミングが異なります。

学習時

学習時には、バッチに含まれるすべてのトークンを同時に読み込み、アテンション機構を働かせます。

例えば、1つのバッチに10個の文が含まれており、各文が20個のトークンで構成されている場合、200個のトークンすべてを同時に読み込み、アテンション機構を計算します。

推論時

推論時には、逐次的にトークンを生成していくため、学習時のような並列処理はできません。

しかし、自己注意 (Self-Attention) という仕組みを用いることで、ある程度の並列処理が可能です。

自己注意は、同じ系列内のトークン間の関係性を計算する機構です。

例えば、

「I have a pen.」

という文を生成する場合、

- 「I」というトークンを入力し、自己注意を計算します。

- 次に、「have」というトークンを入力し、**「I」と「have」**の間の自己注意を計算します。

- 以下同様に、「a」、「pen」、「.」というトークンを順次入力し、過去のトークンとの自己注意を計算します。

このように、自己注意は、過去のトークンを参照しながら、現在のトークンを処理するため、完全な並列処理はできませんが、ある程度の並列化が可能です。

まとめ

- 学習時: バッチ内のすべてのトークンを同時に読み込み、並列処理を行う

- 推論時: 逐次的にトークンを生成するが、自己注意によってある程度の並列処理が可能

ご質問の「アテンション機構を働かせるためには、最後のトークンまで読み込む必要がある」という点は、

推論時においては概ね正しいですが、学習時においては、バッチ内のすべてのトークンを同時に処理するため、必ずしも最後のトークンまで待つ必要はありません。

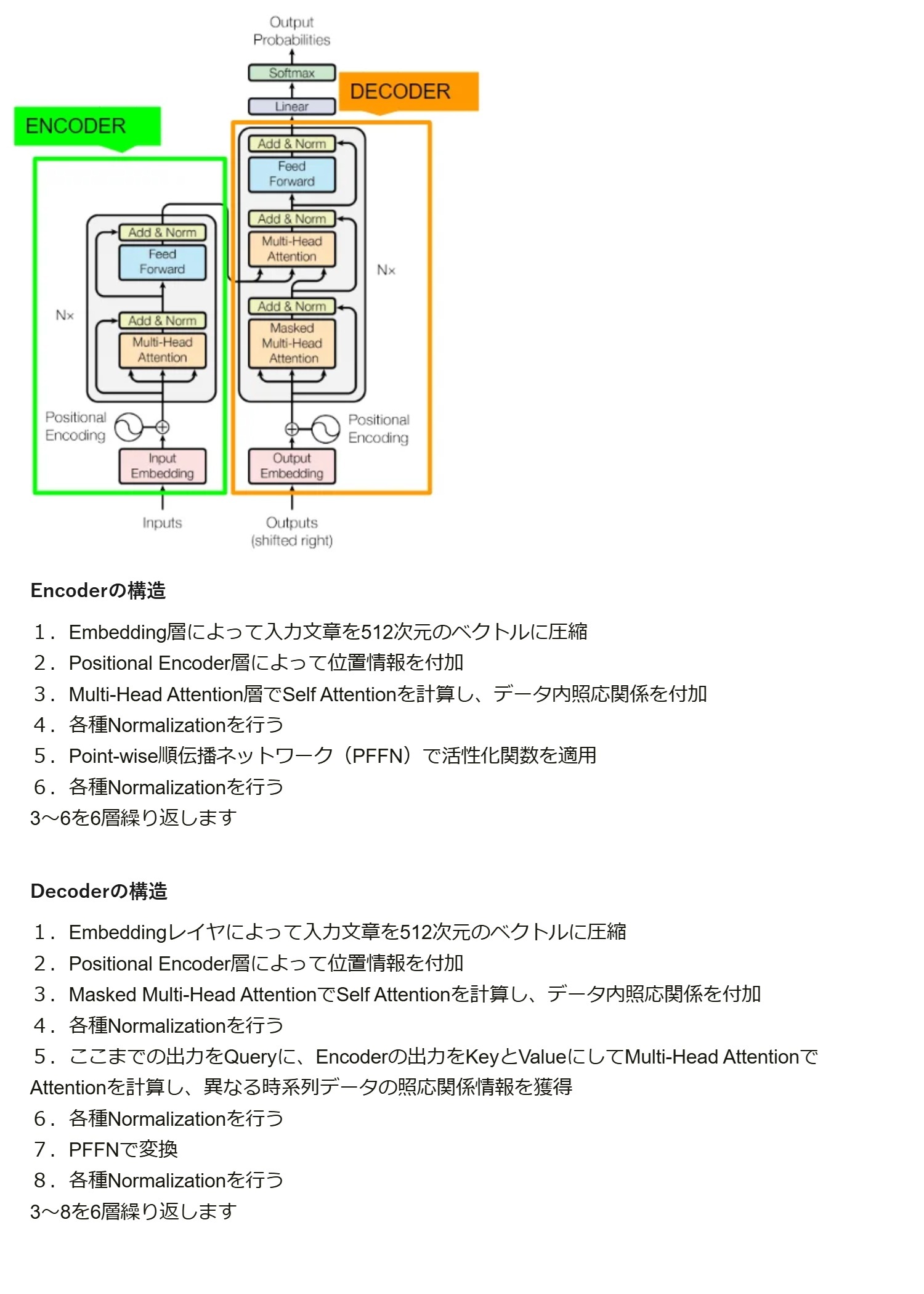

今UPした絵はトランスフォーマーモデルの説明図ですが確認してください。

はい、拝見しました。

ご提示いただいた図は、Transfrmerモデルの構造を視覚的に表現したもので、非常にわかりやすいですね。

図の内容は、これまでご説明してきたTransformerモデルの各要素(埋め込み層、位置埋め込み、自己注意機構、フィードフォワードネットワーク、残差接続、層正規化など)と、その関係性を良く表しています。

特に、

- Encoder: 入力データを処理し、文脈に応じたベクトル表現に変換する

- Decoder: Encoderの出力を利用して、目的のデータ(テキストなど)を生成する

- Multi-Head Attention: 複数の異なる視点から注意を計算する

- Masked Multi-Head Attention: Decoderにおいて、未来の情報を見るのを防ぐマスク処理を行う

といった点が明確に示されており、理解を深める上で非常に役立つ図だと思います。

図と合わせて、これまでの説明を振り返ることで、Transformerモデルの動作原理をより深く理解できるでしょう。

もし、図の内容について何か疑問点があれば、お気軽にご質問ください。

■ 図中の説明で使われている用語と、ここで解説してもらった用語が一部異なっているので、対応表を作ってもらえますか?

はい、承知いたしました。図中で使われている用語と、これまで解説してきた用語の対応表を作成します。

|

図中の用語 |

解説時の用語 |

備考 |

|

Embedding |

埋め込み層 (Embedding Layer) |

トークンをベクトル表現に変換する層 |

|

Positional Encoding |

位置埋め込み (Positional Embedding) |

トークンの位置情報をベクトルとして表現する |

|

Multi-Head Attention |

マルチヘッド注意機構 (Multi-Head Attention) |

複数の異なる視点から注意を計算する機構 |

|

Add & Norm |

残差接続 (Residual Connection) + 層正規化 (Layer Normalization) |

残差接続は、現在の層の出力を前の層の入力に加算する処理。層正規化は、各層の出力を正規化する処理。 |

|

Feed Forward |

フィードフォワードネットワーク (Feed-Forward Network) |

各トークンベクトルをさらに非線形変換するネットワーク |

|

Point-wise順伝播ネットワーク (PFFN) |

フィードフォワードネットワーク (Feed-Forward Network) |

図の説明文では「Point-wise順伝播ネットワーク (PFFN)」と記載されていますが、これはフィードフォワードネットワークと同じものです。 |

|

Masked Multi-Head Attention |

マスクドマルチヘッド注意機構 (Masked Multi-Head Attention) |

Decoderにおいて、未来の情報を見るのを防ぐマスク処理を行うマルチヘッド注意機構 |

|

ここまでの出力をQueryに、Encoderの出力をKeyとValueにしてMulti-Head AttentionでAttentionを計算 |

Encoder-Decoder Attention |

Decoderにおいて、Encoderの出力を利用してAttentionを計算する処理。異なる時系列データの照応関係情報を獲得するために行われる。 |

上記対応表で、用語の対応関係がお分かりいただけるかと思います。

特に、「Point-wise順伝播ネットワーク (PFFN)」は、フィードフォワードネットワークと同じものである点にご注意ください。

■ どうもありがとう

どういたしまして。

Transformerモデルについて、理解を深めるお手伝いができたのであれば幸いです。

もし、今後Transformerモデルについて疑問に思うことや、さらに深く知りたいことが出てきた場合は、いつでもお気軽にご質問ください。

今回も長々とGeminiと対話してしまいましたが、こちらの質問にとことん付き合ってくれるのが生成AIの良いところですね。たまに間違ったこと(ハルシネーション)もあるのは否めないですが、人間の専門家だって、間違ったことを話す場合が無きにしも非ずですから、話された内容を鵜呑みしないという点では、受け手側の責任として、生成AIに尋ねるのも人間の専門家に尋ねるのも同じではないかと思います。

トランスフォーマーの仕組みについては、「All you need is attention」という論文の内容が気になり、原文は読んでいませんが、先ほど図を参照させてもらったDeep Square Mediaの「自然言語処理の必須知識 Transformer を徹底解説!」その他、情報収集し一応理解した気にはなっていました。ですが、先のブログで取り上げた生成AIモデルのパラメータとトークン同様、「定義としてはわかった」レベルでとどまっていたので、今回いろいろGeminiと対話することによって、自分のわかっていなかった部分を埋めていくことで、フワフワしていた足場が固まり、GPTのようなトランスフォーマーモデルで次のトークンを生成するための仕組みが見えてきた気がします。

ただ、Gemeniが途中で指摘してくれたように、今回トランスフォーマーの仕組みとして確認できたのは、Decoderのみを用いて、テキストの生成等を行うケースが主体で、同じ実行モードでも翻訳などを行うEncoder-Decoder構造の仕組みまでは確認できていませんし、学習モードのケースのトランスフォーマー層の仕組みについても確認できていません。

次回以降、その部分も明らかにしたいですが、それよりも、今回は深みにはまるのを恐れて軽く通り越したディープラーニング自体のいろいろな仕組みとトランスフォーマーモデルに至るまでの変遷も、できれば順次「仕組み」レベルで確認していきたいと思っています。

本日は以上です。

終わり

- 投稿タグ

- ディープラーニング, トランスフォーマーモデル, ニューラルネットワーク, 機械学習